**Threshold Function(임계 함수)**를 보여주고 있으며, 입력값이 0 이상이면 출력이 1, 0 미만이면 출력이 0으로 설정되는 단순한 이진 출력 함수입니다. 이 함수는 주로 **퍼셉트론(Perceptron)**에서 뉴런이 활성화될지 여부를 결정하는 데 사용됩니다.

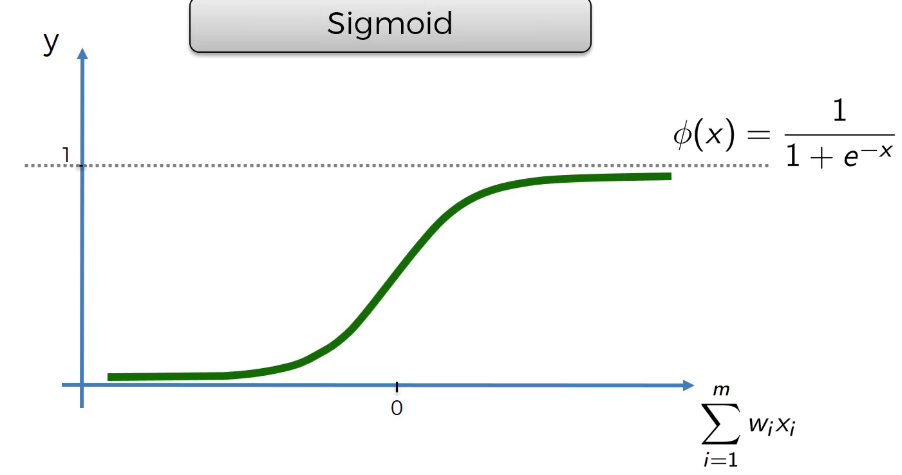

Sigmoid 함수를 보여주며, 출력 값이 0과 1 사이로 변환되는 형태입니다. Sigmoid 함수는 입력값이 클수록 출력이 1에 가까워지고, 작을수록 출력이 0에 가까워지는 특성을 가집니다.

ReLU (Rectified Linear Unit) 활성화 함수를 보여줍니다. ReLU 함수는 입력이 0보다 크면 그대로 출력하고, 0 이하일 경우에는 0을 출력하는 함수로, 신경망에서 널리 사용됩니다.

tanh (하이퍼볼릭 탄젠트) 함수를 보여줍니다. 이 함수는 입력값을 -1에서 1 사이로 변환하며, 출력 값이 0을 중심으로 대칭적인 성질을 가집니다. Tanh 함수는 주로 시그모이드 함수보다 더 넓은 범위에서 값을 출력하여, 학습 성능을 개선하는 데 사용됩니다.

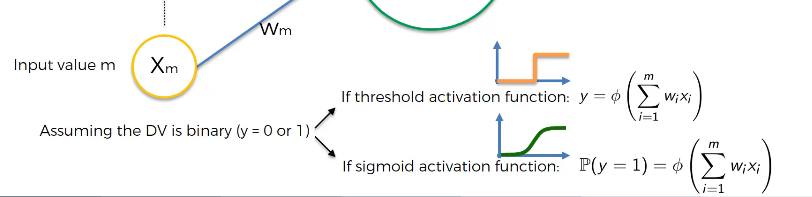

- 이진분류 문제시에는 활성화 함수로 threshold와 sigmoid함수가 사용가능하다.

히든 층에서는 ReLU(Rectified Linear Unit) 활성화 함수가 사용되고, 출력층에서는 시그모이드(Sigmoid) 활성화 함수가 사용됩니다.

- ReLU는 히든 레이어에서 주로 사용되는 활성화 함수로, 입력이 0보다 작을 때는 0을 출력하고, 그 외에는 입력 그대로를 출력합니다. 이는 기울기 소실 문제를 완화하고, 학습 속도를 높이는 데 도움이 됩니다.

- Sigmoid는 출력값을 0과 1 사이로 변환해주기 때문에, 이진 분류와 같은 확률적 예측이 필요한 경우 출력층에서 자주 사용됩니다.

이 구조는 이진 분류 문제에서 많이 사용되는 일반적인 신경망 아키텍처입니다.

'딥러닝 > 인공신경망' 카테고리의 다른 글

| 05. 경사하강법 (0) | 2024.10.10 |

|---|---|

| 04. 신경망의 학습법(퍼셉트론) (0) | 2024.10.10 |

| 03. 신경망의 원리 (0) | 2024.10.10 |

| 01. Neuron(뉴런) (0) | 2024.10.10 |